A generatív AI a mesterséges intelligencia egy formája, amely az általa megtanult adatok alapján képes új tartalmat, elsősorban szöveget vagy képet, nem ritkán videót és zenéket létrehozni. A generatív AI jellemzően nagyméretű adatbázisból tanul, mintákat ismer fel benne, és ezek alapján hoz létre egyedi - vagy ha úgy jobban tetszik, kreatív - tartalmakat.

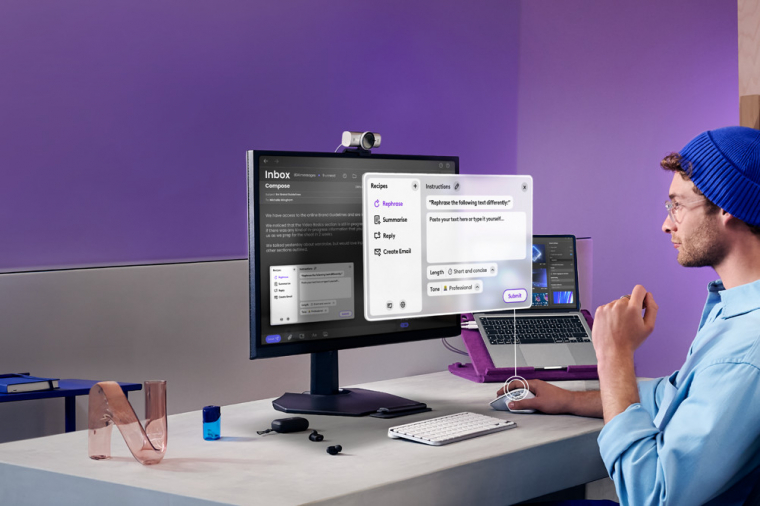

A generatív mesterséges intelligencia nemcsak a szavakat és azok jelentését tudja, hanem - szinte - tökéletesen kontextusba is képes helyezni őket, felismeri az egyes kifejezések közötti árnyalatnyi különbségeket, közvetlen és hivatalos formában is tud fogalmazni, sőt ha a helyzet úgy hozza, még egy-egy viccet is képes elereszt. A generatív AI-t elsősorban, de nem kizárólagosan szövegek és képek létrehozására használják. Emellett képes akár zenét komponálni vagy videót előállítani. A Microsoft-féle VASA-1 például egyetlen jó minőségű fénykép és egy hangfelvétel alapján olyan videót renderel, amelyen az alany tulajdonképpen bármit mondhat.

Az AI körüli hype-ot az OpenAI indította el, amikor a ChatGPT-t mindenki számára ingyenesen elérhetővé tette 2022 végén. A publikus verzió a 3.5-ös változat, ezt bárki ingyenesen használhatja, akár felhasználói fiók létrehozása nélkül is. Van viszont nála fejlettebb modell is, ezt már csak előfizetési díjért cserébe lehet munkára fogni. Természetesen minél fejlettebb egy generatív AI, annál inkább képes olyan munkára, amely megszólalásig hasonlít arra, mintha az adott tartalmat ember készítette volna. Ez abból a szempontból jó, hogy a fejlettebb generatív AI "jobban használható", viszont a fejlettség egyszersmind azzal is jár, hogy nehezebb megkülönböztetni a gép és az ember alkotta tartalmakat egymástól. Pedig ez egy olyan fontos kérdés, ami már most is felmerül rengeteg, az interneten elérhető tartalom esetében. A jövő generációjának már nem azt kell megtanulnia, hogyan kell keresni az interneten, hanem azt, hogyan kell ellenőrizni a tartalom valódiságát; értve ezalatt, hogy az adott írást például ember vagy gép készítette-e, és azt is, hogy mennyi az adott "sztori" valóságtartalma.

A generatív AI egy sor feladatban nyújthat kisebb-nagyobb segítséget. Írhat például egy ismert műhöz folytatást néhány egyszerűbb iránymutatás alapján, de teljesen új történet is születhet segítségével. Össze tud foglalni egy hosszabb dokumentumot pár mondatban vagy bekezdésben, vagy ha keresni szeretnél valamit a neten, akkor is tudja azt könnyen emészthető formában tálalni. A ChatGPT emellett persze számos más feladatra is használható (önéletrajzot ír, segít eldönteni egy-egy vitás kérdést, nyelvet tanít, programkódot készít vagy ellenőriz, ötleteket ad az első randira és így tovább), de azokkal viszonylag ritkán találkozni a neten.

Gép vagy ember készítette?

Van néhány olyan terület, ahol a ChatGPT problémákat okozhat: ilyen a média, a közösségi média és az oktatás. A médiában itt-ott már most is találkozni gép által írt cikkekkel (persze nem a neves hírportálokon, de ennek is eljöhet az ideje), a közösségi médiában pedig az eleve burjánzó fake news-jelenségnek adott újabb lökést az AI. Az oktatásban problémát okozhat, ha a dolgozatokat nem a diák, hanem a gép készíti el, de ennek fordítottjaként az is, amikor a tanár egy ártatlan diákot vádol azzal, hogy csalt, és generatív AI-val készíttette el a beadandó irományt.

A kérdés adja magát: meg lehet mondani egy szövegről, hogy azt mesterséges intelligencia készítette-e vagy sem? A helyzet az, hogy ha az adott írás készítője nem ismeri el, akkor minden kétséget kizárólag nem. A dolog több tényező függvénye, és persze vannak azért árulkodó jelek is, de a válasz az, hogy egyértelmű ítélet nem hozható; az alábbiakban azért árnyaljuk kicsit a képet.

Induljunk ki abból, hogy a ChatGPT (és a rá épülő Copilot) vagy a Google-féle Gemini célja az, hogy olyan minőségben kommunikáljon, mintha azt élő, gondolkodó emberek tennék. Ehhez jó alapot jelentenek az adatbázisok, valamint az, hogy a nyelvi minták, a mondatszerkesztés és az, ahogyan a szavakat képezzük, egzakt szabályokkal tökéletesen leírhatók.

A valóságban a szöveg mégsem csak attól lesz szöveg, hogy a szavak a megfelelő alakban és sorrendben követik egymást. Többek között azért nem, mert a megfelelő alak és sorrend a szabályok betartása mellett rugalmas. Kicsit minden ember máshogyan beszél, máshogyan kommunikál - eltérően hibázik. Ezek az apróságok, ezek a nüánsznyi különbségek azok, amik egyedivé, élővé, adott esetben személyessé teszik a kommunikációt. Meg persze az, hogy ezek az apró különbségek és hibák koherensek, vagyis az egész szövegre ugyanúgy jellemzők - nincsenek a stílusba oda nem illő szavak, nincsenek eltérő stílusban íródott bekezdések és így tovább.

Nyilván a generatív mesterséges intelligencia is képes tartalom előállítására "egyéni stílusban", koherens módon (hiszen éppen azért hozták létre, hogy ezt megtegye), a kérdés csak az, hogy mennyire. "Szerencsére" egyelőre még nem tökéletesen, így van még esélyünk arra, hogy kiderítsük, az adott szöveg ember vagy gép által készült-e. Ez viszont sok más tényező függvénye is; egy önéletrajz vagy egy hivatalos dokumentum például jellemzően kötött formátum, éppen úgy, mint egy tudományos cikk. Ha a szerző egy ilyen dokumentumnál a mesterséges intelligencia, akkor az nehezebben azonosító, ha egyáltalán.

A történelem ismétli önmagát, de van fejlődés

Bő 25 éve, amikor az internet kezdett széles körben elérhetővé válni, az iskolákban, egyetemeken viszonylag hamar jelentkezett az a probléma, hogy a beadandókat a diákok nem saját maguk írták meg, hanem letöltötték azt valahonnan az internetről. Több szoftver is készült, ami képes volt megkeresni a dolgozatokban azokat a részeket, amelyek máshol már megjelentek. Nos, valami hasonló jelenség kezd kibontakozni a mesterséges intelligencia kapcsán is, de persze azzal a fontos különbséggel, hogy a mesterséges intelligenciával készített tartalmak egyediek. Ebből adódóan ugyanis sokkal nehezebb eldönteni egy, valamilyen generatív AI által készített tartalomról, hogy mesterséges intelligencia vagy ember készítette-e.

Hogy a feladat mennyire bonyolult, azt jól jelzi, hogy a ChatGPT készített egy saját algoritmust, ami elvileg képes volt eldönteni, hogy egy adott szöveget mesterséges intelligencia vagy ember készítette-e, ám az eredmény annyira megbízhatatlan volt, hogy az OpenAI rövid idő elteltével le is kapcsolta a szolgáltatást. Ez mondjuk nem akadályozott meg más fejlesztőket abban, hogy erre a célra saját eszközt fejlesszenek, de ha a ChatGPT-t fejlesztő cég saját megoldása nem volt elég megbízható (azaz a ChatGPT-t fejlesztő cég sem tudja megmondani egy szövegről, hogy azt ChatGPT alkotta-e meg), akkor jogos a kérdés, hogy vajon más fejlesztők terméke mennyire megbízható. A tapasztalatok szerint egyébként a fals pozitív találatokból van több, vagyis a platformok (például ZeroGPT) tévesen jelzik egy szövegről, hogy azt AI alkotta. Ezzel pedig az a gond, hogy ha a pontosság nem 100%, akkor az eredmény máris nem használható például vizsgák értékelésekor. 95%-os pontosság már azt jelzi, hogy 20-ból 1 ítélet hibás, vagyis egy átlagos méretű osztályban legalább egy tanuló esetében tévedni fog a mesterséges intelligenciát felismerő AI.

A mesterséges intelligencia által generált szöveg felismerése főleg minták keresése alapján működik. Éppen ezért a kötött struktúrájú dokumentumoknál (önéletrajz, tudományos szöveg stb.) ez nem lehetséges, ráadásul az AI által megírt szöveget pillanatok kérdése csupán módosítani - bekezdéseket mozgatni, egy-egy szót átírni nem nagy dolog. Illetve egy alapos átolvasással a szöveg korrektúrázható, innentől kezdve pedig már azon is lehet vitázni, hogy végső soron ki az, aki valójában a szöveget elkészítette.

Segít a magyar nyelv

A ChatGPT és társai adathalmazokból tanulnak, a legtöbb adat pedig angol nyelven áll rendelkezésre - éppen ezért nem túl meglepő, hogy az AI angol nyelven sokkal jobb teljesítményre képes, mint magyarul. Az viszont érdekesebb, hogy magyar nyelven is mennyire jól működik a dolog, ám jellemzően nem tökéletes, és ez nekünk, magyaroknak némi helyzeti előnyt jelent. A magyar a legtöbb szakértő szerint benne van az öt legnehezebben megtanulható nyelvben, többek között a ragozás miatt. Ez pedig pontosan az a terület, ahol a mesterséges intelligencia bele-belehibázik. Az alábbi pár mondat úgy született, hogy a ChatGPT-t megkértük, írjon egy bevezetőt egy olyan cikkhez, amelynek témája a mesterséges intelligencia alkotta szöveg felismerése.

"A mesterséges intelligencia által generált szövegek felismerése és értelmezése egy izgalmas és aktuális terület. Ebben a cikkben megvizsgáljuk, hogy miként lehet azonosítani, hogy egy adott szöveg valóban mesterséges intelligencia által létrehozott-e, vagy emberi szerző alkotta. Vizsgáljuk azokat a jellemzőket és technikákat, amelyek segíthetnek az AI által generált tartalom felismerésében, és megosztjuk néhány hatékony módszert, amellyel a felhasználók jobban megérthetik, hogy milyen tartalommal találkoznak az online világban."

A megosztJUK egy olyan hiba, amit ember általában nem vét, de persze még nem kizárt, hogy becsúszik egy ilyen - hiszen ha második átolvasásra a mondat felépítése jelentősen változik, akkor előfordulhat, hogy egy szó kijavítása elmarad: például ha az első verzió az volt, hogy "megosztjuk azokat a módszereket". Ez rögtön mutatja is, hogy az ilyen jellegű hibák, bár utalhatnak arra, hogy a szöveget mesterséges intelligencia készítette, nem biztos jelei ennek.

Az egész szöveget egyben kell nézni és vizsgálni. Ha például a fenti hiba csak néhány helyen fordul elő, akkor az inkább emberi vétség, ha viszont ismétlődik, és jellemzően ugyanolyan környezetben, ugyanaz a minta jelenik meg, az inkább AI-ra utal. További árulkodó jel lehet, ha egy-egy szó kilóg a szöveg stílusából, vagy felesleges - a mesterséges intelligencia hajlamos például töltelékszavakat használni az egyedi stílushoz. Vegyük például ezt az AI által generált mondatot:

"Whether you're a student, a content creator, or a curious reader, understanding the telltale signs of AI-written material can empower you to navigate the vast sea of information more effectively."

Ennek elején a felsorolásnál kilóg a "curious reader" (kíváncsi olvasó); bár önmagában nincs vele semmi gond, semmi nem indokolja a jelzős szerkezetet az olvasó előtt úgy, hogy közben a tanuló vagy a tartalomkészítő nem kap valami hasonlót. Tartalmilag helyes, formailag helyes, de a lóláb, ha csak nagyon kicsit is, mégis kilóg. Az ehhez hasonló "hibák" elég gyakoriak, itt egyszerűen arról van szó, hogy az AI a közbeszédben nem túl gyakran előforduló szavakat használ. Valahogy úgy, mint amikor valaki fel szeretne vágni a társaságban azzal, hogy különleges szavakat mond.

Ehhez hasonló jel lehet, ha a dokumentum hangneme nem megfelelő; például egy hivatalos levél közvetlen hangnemben készül, vagy egy barátnak címzett írás úgy kezdődik, hogy Tisztelt X.Y…

A mesterséges intelligencia jellemző tulajdonsága továbbá, hogy jellemzően nem tudja eldönteni, a rendelkezésére álló információk közül melyik súlya nagyobb, melyik az, amelyik fontosabb. Ez - megint csak a teljes szöveget vizsgálva - anomáliákat eredményezhet. Gyakori például a túlmagyarázás, amikor a mesterséges intelligencia kétszer vagy akár még többször megismétli ugyanazt az információt picit más mondatszerkezettel. Illetve gyakran elfordul az is, hogy - mondjuk egy keresésre adott szöveges válaszban - a releváns információkhoz nem a súlyukhoz tartozó terjedelem, részletezettség, kifejtettség tartozik. Főleg a túlmagyarázás jellemző, aminek legfontosabb jele az, hogy a szövegben üres mondatok vannak, azaz olyan mondatok, amelyek hosszúak, de tényleges információtartalmuk pár szóval is elmondható.

A mesterséges intelligencia relatíve gyakran nem találja el azt sem, hogy egy-egy mondatnak milyen hosszúnak illik lennie. Jellemzően túl hosszú, túl komplex mondatok árulkodnak arról, hogy az adott szöveget gép készítette, egész egyszerűen azért, mert a ChatGPT és társai a mondatot annak hosszától függetlenül értik, nincs meg bennük az a fék, amely megálljt parancsolna.

Könnyen elfordulhatnak logikai buktatók is; a mesterséges intelligencia által generált szövegben, főleg ha az hosszú, megesik, hogy az első rész és a második rész tartalma részben ellentétes egymással. A generatív AI a jelenlegi fejlettségi szinten bár képes logikai kapcsolatokat is értelmezni, ez egyelőre az általa értelmezett információkra korlátozódik, az általa megírt szövegben lehetnek logikai bukfencek. Főleg akkor, ha az összefüggések matematikai modellekkel nem írhatók le.

Öveket bekapcsolni

A fentiekből látszik, hogy a kérdés bonyolult, és sajnos a helyzet az, hogy a későbbiekben sem lesz egyszerű - ugyanis a cél az emberi viselkedés, az emberi tudás lemásolása. Éppen ezért, ahogyan a generatív AI fejlődik, egyre kisebb lesz az eltérés az ember és a gép alkotta szövegek között. Most még vannak szövegek, amiről ordít, hogy nem ember írta, de olyan módszer, ami biztosan megmondja egy szövegről, hogy ki készítette, már most sincsen. És szinte biztos, hogy nem is lesz.